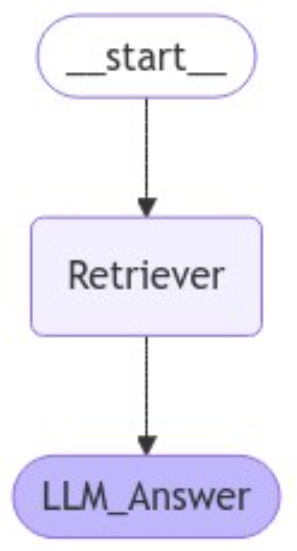

Long-Context LLMs Meet RAG: Overcoming Challenges for Long Inputs in RAG 1. IntroductionRAG시스템은 대규모 언어 모델이 외부 정보를 활용하여 생성 품질을 높일 수 있도록 설계되었습니다. 특히, 긴 문맥을 처리할 수 있는 LLM이 발전하면서 더 많은 검색 결과를 활용하여 지능형 답변을 생성할 수 있는 가능성이 열렸습니다. 하지만 연구에 따르면 검색 결과가 많아질수록 성능이 초기에는 향상되다가, 이후에는 불필요하거나 부정확한 정보(Hard Negatives)로 인해 성능이 저하되는 문제가 발생합니다.이 글에서는 논문 "Long-Context LLMs Meet RAG: Overcoming Challenges for Long Inputs i..